Effektive IRB-Modellierung: Wie kann die Datenerstellung beschleunigt werden?

In der Welt des Kreditrisikomanagements spielen Daten eine wesentliche Rolle. Insbesondere bei der Internal Ratings Based (IRB) Modellierung der Kreditrisikoparameter sind qualitativ hochwertige Daten unerlässlich. Doch die Datenerstellung kann zeitaufwendig und ressourcenintensiv sein, was zu Verzögerungen bei der Finalisierung und letztendlich der Implementierung von IRB-Modellen führen kann.

Als langjährige Expertin im Bereich des Risikomanagements habe ich mich intensiv mit der Herausforderung der Datenerstellung in der IRB-Modellierung auseinandergesetzt. In diesem Artikel möchte ich daher einige bewährte Praktiken vorstellen, wie die Datenerstellung beschleunigt werden kann, um die Effizienz und Genauigkeit von IRB-Modellen zu verbessern.

Grundlagen der IRB-Modellierung und Datenanforderungen

Der IRB-Ansatz ermöglicht es Banken, ihre eigenen internen Risikoeinschätzungen zu verwenden, um das Kreditrisiko zu bewerten. Dabei spielen verschiedene Daten eine wichtige Rolle, darunter historische Kreditdaten, Bonitätsinformationen, wirtschaftliche Indikatoren und mehr.

Während einer meiner Projekte standen wir vor der Herausforderung, eine umfangreiche Datenbasis für die Implementierung eines neuen IRB-Modells zu schaffen. Die Beschaffung und Validierung dieser Daten erwies sich als deutlich zeitaufwendiger und komplexer als initial innerhalb des Projekts geplant. Diese Erfahrung hat mir verdeutlicht, wie entscheidend ein effizienter Datenerstellungs-Prozess für den Erfolg ist.

Für eine genaue und zuverlässige Risikobewertung sind Daten mit gesicherter Datenqualität unerlässlich. Banken müssen über eine umfangreiche Datenhistorie verfügen, um die verschiedenen Komponenten der IRB-Modelle zu modellieren. Zu den wichtigsten Datenanforderungen gehören:

Kreditnehmerdaten

Hierzu gehören Daten über den Kreditnehmer selbst, für Firmenkundengeschäft beinhaltet dies sowohl branchenspezifische Kennzahlen als auch geografische Informationen

Finanzdaten

Diese beinhalten Informationen über die Bonitätshistorie, finanzielle Leistungsfähigkeit, Verschuldung und das Einkommen.

Trendinformationen

Dies beinhaltet historische Veränderungen von Umsatz/Ertrag, Einkommen und Verschuldungsentwicklung.

Verhaltensinformationen

Ein umfassendes Verständnis der Kredithistorie von Kreditnehmern ist entscheidend für die Bestimmung ihrer Ausfallwahrscheinlichkeit. Historische Daten über Zahlungsschwierigkeiten, Kreditausfälle und -rückzahlungen ermöglichen es, Risikoprofile für einzelne Kreditnehmer oder Kreditportfolios zu erstellen.

Die Datenanforderungen für die IRB-Modellierung sind vielfältig und anspruchsvoll. Banken müssen sicherstellen, dass ihre Datenqualität hoch ist und dass sie über effektive Prozesse zur Datenerfassung, -validierung und -verarbeitung verfügen, um genaue Risikoeinschätzungen zu gewährleisten.

Als Modellentwicklerin habe ich in den Projekten immer wieder erlebt, dass Daten losgelöst vom Bankprozess interpretiert wurden, und damit fachlich in einem falschen Zusammenhang gesetzt wurden. Dabei ist eine enge Zusammenarbeit mit verschiedenen Abteilungen innerhalb der Bank unbedingt notwendig, um sicherzustellen, dass die Modelle genaue, aussagekräftige und anwendbare Ergebnisse lieferten. Zusätzlich ist eine umfassende Dokumentation der Gegebenheiten unerlässlich, damit der Aufwand für zukünftige Prozesse reduziert werden kann.

Herausforderungen bei der Datenerstellung für die IRB-Modellierung

Trotz der entscheidenden Bedeutung von qualitativ hochwertigen Daten für das Risikomanagement stehen die Mitarbeiter:innen in den quantitativen Teams oft vor einer Reihe von Herausforderungen bei der Erzeugung der Modellierungs-/Validierungsdatensätze. Diese Herausforderungen können die Effizienz der Modellentwicklung beeinträchtigen und zu Verzögerungen bei der IRB-Modellierung führen. Im Folgenden werden einige der Hauptprobleme erläutert, die Banken bei der Datenerfassung und -verarbeitung für die IRB-Modellierung begegnen:

Mangel an qualitativ hochwertigen Daten

Einer der größten Herausforderungen besteht darin, über ausreichend qualitativ hochwertige Daten zu verfügen, um genaue Risikoeinschätzungen vorzunehmen. Oftmals sind historische Daten unvollständig, ungenau oder nicht für die Zwecke der Modellierung geeignet. Dies kann zu Verzerrungen führen und die Aussagekraft der Modelle beeinträchtigen.

Zeit- und Ressourcenaufwand für die Datenerfassung und -validierung

Die Beschaffung und Validierung von Daten ist ein zeitaufwendiger und ressourcenintensiver Prozess. Banken müssen verschiedene interne und externe Datenquellen durchsuchen, um die erforderlichen Daten zu sammeln, und diese Daten anschließend gründlich validieren, um ihre Qualität und Zuverlässigkeit sicherzustellen. Dies erfordert oft erhebliche personelle Ressourcen.

Komplexität der Daten

Die Daten, die für die Modellierung benötigt werden, können oft komplex und heterogen sein. Banken müssen verschiedene Datenformate und -strukturen berücksichtigen und möglicherweise Daten aus verschiedenen Quellen (wie beispielsweise historisch bedingte unterschiedliche Kernbankensysteme) integrieren. Die Komplexität der Daten kann den Datenerfassungsprozess erschweren und zusätzliche Herausforderungen bei der Datenverarbeitung und -analyse mit sich bringen.

Auswirkungen unvollständiger oder ungenauer Daten auf die Modellgenauigkeit

Unvollständige oder ungenaue Daten können die Genauigkeit und Zuverlässigkeit der IRB-Modelle erheblich beeinträchtigen. Wenn Datenlücken bestehen oder Datenfehler vorliegen, können die Modellergebnisse verzerrt sein und zu falschen Risikoeinschätzungen führen. Dies kann zu finanziellen Verlusten führen und das Vertrauen der Stakeholder in die Modelle beeinträchtigen.

Verständnis der Bankprozesse

Um die Qualität und Relevanz der Daten zu beurteilen, die für die Entwicklung von Kreditrisikomodellen verwendet werden, ist es wichtig zu verstehen, wie diese Daten in den Bankprozessen generiert werden. Durch das Wissen um die internen Abläufe können die Analyst;inen besser beurteilen, wie sich die Modellierungsergebnisse auf die Geschäftsentscheidungen auswirken.

Dokumentation

Die Dokumentation der Daten, einschließlich ihrer Definition, Wertebereiche, historischen Verfügbarkeit sowie Quellen und Transformationen ist von entscheidender Bedeutung. Sie ermöglicht ein besseres Verständnis und hilft bei der Identifizierung von potentiellen Risiken und Schwachstellen. Bei Änderungen in der Dateninfrastruktur können die Auswirkungen leichter bewertet werden.

Der Mangel an qualitativ hochwertigen Daten kann erhebliche Auswirkungen auf die Effektivität und Zuverlässigkeit von IRB-Modellen haben. Banken müssen daher sicherstellen, dass sie über effektive Strategien zur Datenbereinigung, -validierung und -verarbeitung verfügen, um sicherzustellen, dass ihre Modelle genaue und aussagekräftige Ergebnisse liefern. Im nächsten Abschnitt werden einige bewährte Praktiken vorgestellt, wie Banken diese Herausforderung erfolgreich angehen können.

Während der Entwicklung eines neuen IRB-Modells stießen wir auf erhebliche Schwierigkeiten aufgrund unzureichender Datenqualität, insbesondere fehlende Informationen. Insbesondere die historischen Kreditdaten wiesen einige Lücken auf, die die Genauigkeit unserer Modelle beeinträchtigen würden, wenn diese nicht entsprechend bei der Modellierung berücksichtigt werden. Wir verbrachten Wochen damit, die Daten zu analysieren und zu validieren, bevor wir überhaupt mit der eigentlichen Modellentwicklung beginnen konnten. Diese Erfahrung verdeutlichte, wie wichtig es ist, die Datenqualität von Anfang an zu berücksichtigen und robuste Datenqualitätsprozesse zu implementieren.

Die Sicherheitsspanne (MoC) bei der PD und LGD Schätzung

Die Margin of Conservatism (Sicherheitsspanne) spielt eine wesentliche Rolle bei der PD- (Probability of Default) und LGD- (Loss Given Default) Schätzung gemäß den Leitlinien der Europäischen Bankenaufsichtsbehörde (EBA). Diese Sicherheitsspanne ist eine wichtige Komponente, um die Unsicherheit in den Schätzungen zu berücksichtigen und ein angemessenes Risikomanagement zu gewährleisten.

Die EBA-Leitlinien legen fest, dass Banken bei der PD- und LGD-Schätzung eine ausreichende Sicherheitsspanne verwenden müssen, um potenzielle Modellunsicherheiten und Verzerrungen zu berücksichtigen. Diese Sicherheitsspanne sollte einen konservativen Puffer um die geschätzten PD- und LGD-Werte bieten, um das Risiko von Unter- oder Überschätzungen zu reduzieren.

Dabei gibt es verschiedene Faktoren, die die Sicherheitsspanne bei IRB-Modellen beeinflussen können:

Dabei gibt es verschiedene Faktoren, die die Sicherheitsspanne bei IRB-Modellen beeinflussen können:

- Kategorie A Datenmängel: Eine unzureichende Datenqualität oder -quantität kann zu einer größeren Unsicherheit in den Modellprognosen führen und die Notwendigkeit einer größeren Sicherheitsspanne erhöhen.

- Kategorie A Methodische Mängel: Die Methoden und Annahmen, die in einem IRB-Modell verwendet werden, können einen erheblichen Einfluss auf die Genauigkeit der Modellprognosen haben. Änderungen oder Unsicherheiten in diesen Annahmen können zu größeren Sicherheitsspannen führen.

- Kategorie B Prozess-Veränderungen: Relevante Änderungen der Kreditvergaberichtlinien, der Risikobereitschaft, der Inkassorichtlinien und Richtlinien zur Sicherheitenverwertung und -einbringung sowie aller sonstigen Quellen zusätzlicher Unsicherheit können zu Unterschieden in den historisch verwendeten Daten führen und damit die Notwendigkeit einer größeren Sicherheitsspanne erhöhen.

- Kategorie C: Allgemeine Schätzfehler.

Die Margin of Conservatism soll sicherstellen, dass die geschätzten PD- und LGD-Werte angemessen konservativ sind und potenzielle Verluste angemessen berücksichtigen. Banken sollten verschiedene Methoden zur Bestimmung der Sicherheitsspanne verwenden, darunter historische Analysen, Expertenurteile und Sensitivitätsanalysen, um die Unsicherheit in ihren Schätzungen zu quantifizieren.

Es ist wichtig zu beachten, dass je größer die Sicherheitsspanne ist, desto höher sind die Schätzwerte für die Risikoparameter und desto mehr Kapital muss eingesetzt werden.

Gemäß den EBA-Leitlinien muss die Sicherheitsspanne regelmäßig überprüft werden, um sicherzustellen, dass sie den aktuellen Marktbedingungen und Risikoprofilen entspricht.

Eine Verbesserung der Datenqualität kann daher umgehend zu einer Verringerung der Sicherheitsspanne und damit zu einer Verringerung des notwendigen Eigenkapitals führen.

Bei der Erzeugung eines PD-Modells stießen wir immer wieder auf inkonsistente Daten, die sich teilweise sogar widersprachen. Für diverser Risikotreiber wurden Ausreißer festgestellt, das heißt die beobachteten Wertebereiche stimmten nicht mit den Erwartungen überein. Dies wurde bei der Berechnung der Sicherheitsspanne berücksichtigt. Die Bank hat daraufhin bei der Datenerfassung im Kernbankensystem ein Datenvalidierungstool eingesetzt, so dass inkonsistente und fehlerhafte Daten umgehend identifiziert und dann korrigiert wurden. Dies verbesserte die Datenqualität signifikant, so dass die Sicherheitsspanne für das neue PD-Modell reduziert werden konnte.

Best Practices zur Beschleunigung der Datenerstellung

Bei der Entwicklung von IRB-Modellen ist die Beschleunigung der Datenerstellung ein wesentlicher Faktor, um effiziente und zeitnahe Risikobewertungen zu ermöglichen. Um diesen Prozess zu optimieren, haben sich in der Praxis einige bewährte Methoden und Best Practices herausgebildet. Im Folgenden werden einige dieser Best Practices vorgestellt:

Automatisierung der Datenerfassung und -verarbeitung:

Durch die Implementierung automatisierter Prozesse zur Datenerfassung und -verarbeitung können Banken Zeit und Ressourcen sparen. Dies kann beispielsweise durch den Einsatz von Datenextraktions- und Transformationswerkzeugen (ETL) erfolgen, die es ermöglichen, Daten aus verschiedenen Quellen zu sammeln, zu bereinigen und zu integrieren. Ein Beispiel dafür ist die Nutzung von Robotic Process Automation (RPA), um repetitive Datenerfassungsaufgaben zu automatisieren und den menschlichen Arbeitsaufwand zu reduzieren. Je weniger manueller Input bei der Datenerfassung nötig ist, desto weniger fehleranfällig ist der Prozess.

Nutzung von maschinellem Lernen und künstlicher Intelligenz:

Der Einsatz von maschinellem Lernen und künstlicher Intelligenz kann die Datenanalyse und -verarbeitung beschleunigen und die Qualität der Ergebnisse verbessern. Zum Beispiel können Machine-Learning-Algorithmen verwendet werden, um automatisch fehlerhafte oder unvollständige Daten zu identifizieren und zu bereinigen. Ein Beispiel hierfür ist die Anwendung von Natural Language Processing (NLP) zur Extraktion von Informationen aus unstrukturierten Textdaten wie Verträgen, Berichten oder Log-Einträgen.

Etablierung effizienter Datenmanagement- und Governance-Strukturen:

Eine klare Datenmanagementstrategie und -infrastruktur ist entscheidend, um die Datenerfassung zu beschleunigen und die Qualität der Daten sicherzustellen. Dies umfasst die Definition klarer Datenstandards, die Einführung effizienter Datenmanagementprozesse und die Einrichtung eines robusten Datenqualitätsmanagementsystems. Ein Beispiel hierfür ist die Implementierung eines Data Governance Frameworks, das Richtlinien und Verfahren für die Datenerfassung, -speicherung und -nutzung festlegt.

Zusammenarbeit mit externen Datenanbietern und Branchenpartnern:

Banken können die Datenerstellung beschleunigen, indem sie mit externen Datenanbietern und Branchenpartnern zusammenarbeiten, um auf zusätzliche Datenquellen zuzugreifen. Dies kann beispielsweise die Nutzung von Daten von Kreditbüros, Wirtschaftsforschungsinstituten oder anderen Finanzinstitutionen umfassen. Ein Beispiel hierfür ist die Partnerschaft mit einem externen Datenanbieter, um auf umfangreiche historische Kreditdaten zuzugreifen, die für die Modellierung benötigt werden.

Kontinuierliche Verbesserung und Lernzyklen:

Schließlich ist es wichtig, dass Banken einen kontinuierlichen Verbesserungsprozess für ihre Datenerstellungsprozesse implementieren. Dies umfasst die regelmäßige Überprüfung und Aktualisierung der Datenquellen, die Optimierung von Datenvalidierungs- und Bereinigungsprozessen sowie die Einbindung von Feedbackschleifen aus der Modellanwendung. Ein Beispiel hierfür ist die Durchführung regelmäßiger Audits und Reviews der Datenqualität und Prozesse, um potenzielle Engpässe oder Verbesserungsmöglichkeiten zu identifizieren.

Diese Best Practices zur Beschleunigung der Datenerstellung können Banken dabei unterstützen, effiziente und zuverlässige IRB-Modelle zu entwickeln, die fundierte Risikobewertungen ermöglichen. Durch die Implementierung dieser Methoden sparen Banken nicht nur Zeit und Ressourcen, sondern stärken auch ihre Wettbewerbsfähigkeit und verbessern ihre Risikomanagement.

Praxisbeispiele

Um einen realistischen Einblick in die Herausforderungen und Lösungen bei der Beschleunigung der Datenerstellung für die Kreditrisiko-Modellierung zu geben, betrachten wir einige Fallstudien und Praxisbeispiele aus der Finanzbranche. Diese Beispiele vermitteln ein Verständnis für die Vielfalt der Ansätze und Technologien, die Banken einsetzen, um ihre Datenprozesse zu optimieren und effektive Modelle zu entwickeln:

Datenqualitätssicherung durch intensive interne Kommunikation

Eine mittelgroße Bank setzte auf interne Prozesse und strenge Qualitätskontrollen, um die Datenerstellung für ihre IRB-Modelle zu beschleunigen. Anstatt sich auf externe Datenquellen oder Technologien zu verlassen, investierte die Bank in die Schulung ihres internen Teams und implementierte gründliche Validierungsprozesse. Die Mitarbeiter:innen im Kundenmanagement werden über die Ergebnisse der Datenqualitätschecks informiert und bekommen einen Einblick in die Auswirkungen von fehlerhaften Eingaben. Durch regelmäßige Schulungen und Audits konnte die Bank sukzessive sicherstellen, dass ihre Daten von hoher Qualität waren und die Modellentwicklung nicht durch ungenaue oder unvollständige Daten verzögert wurde.

Agile Datenerfassung und iterative Modellentwicklung

Eine innovative Bank setzte auf agile Methoden und iterative Modellentwicklung, um die Datenerstellung zu beschleunigen. Anstatt auf umfangreiche Vorabdatenerhebungen zu setzen, begann die Bank mit der Modellentwicklung auf der Grundlage der verfügbaren Daten und aktualisierte ihre Modelle kontinuierlich, wenn neue Daten verfügbar waren oder sich die Datenqualität existierender Daten verbesserte. Damit nahm die Bank in Kauf, dass die Modellgüte aufgrund der verringerten Datenbasis nicht das Optimum war, was man hätte erreichen können. Durch diesen agilen Ansatz konnte die Bank schnell auf sich ändernde Marktbedingungen reagieren und ihre Modellentwicklung beschleunigen, ohne erheblichen Zeitaufwand für die Überprüfung der Datenqualität zu benötigen.

Integration von ESG-Daten zur Verbesserung der Risikobewertung

Eine führende Bank integrierte Umwelt-, Sozial- und Governance (ESG)-Kriterien in ihre Risikobewertungsmodelle, um zum einen ein umfassenderes Bild der Kreditrisiken zu erhalten und zum anderen die regulatorischen Anforderungen zu erfüllen. Da die Bank über keine eigenen historischen Daten hinsichtlich ESG-Faktoren verfügte, begann sie damit, externe ESG-Datenanbieter zu identifizieren und Partnerschaften mit ihnen einzugehen, um auf umfassende und hochwertige Daten zuzugreifen. Diese Daten umfassten Informationen zu Umweltauswirkungen, sozialen Belangen und Governance-Praktiken von Unternehmen und deren Auswirkungen auf die finanzielle Performance. Durch die Integration von ESG-Daten in ihre Risikobewertungsmodelle konnte die Bank ein besseres Verständnis für die Risiken im Zusammenhang mit Umwelt- und sozialen Faktoren gewinnen. Zeitgleich begann die Bank eine eigene Datenbasis mit diesen Informationen aufzubauen, um in Zukunft eine Modellierung auf eigenen Daten vornehmen zu können.

Schrittweiser Aufbau eines Data Dictionary zum besseren Verständnis

Eine kleine Bank begann im Rahmen eines Risiko-Modellentwicklungsprozesses mit dem Aufbau eines Data Dictionaries. Um unmittelbaren Nutzen aus dem Dictionary ziehen zu können, wurden zunächst die kritischsten Datenelemente definiert und Eigentümer definiert. Nach der Festlegung von Definitionen und Wertebereichen wurden Quellen und Transformationen dokumentiert, sowie die aktuelle als auch historische Verfügbarkeit überprüft. Für diese Kern-Datenelemente wurden gleichzeitig IT-seitig automatisierte Qualitätskontrollen eingeführt. Das Dictionary wächst seitdem sukzessive weiter, so dass der Aufwand hinsichtlich Datenbereitstellung mit jeder Iteration von Modellentwicklungen sinkt.

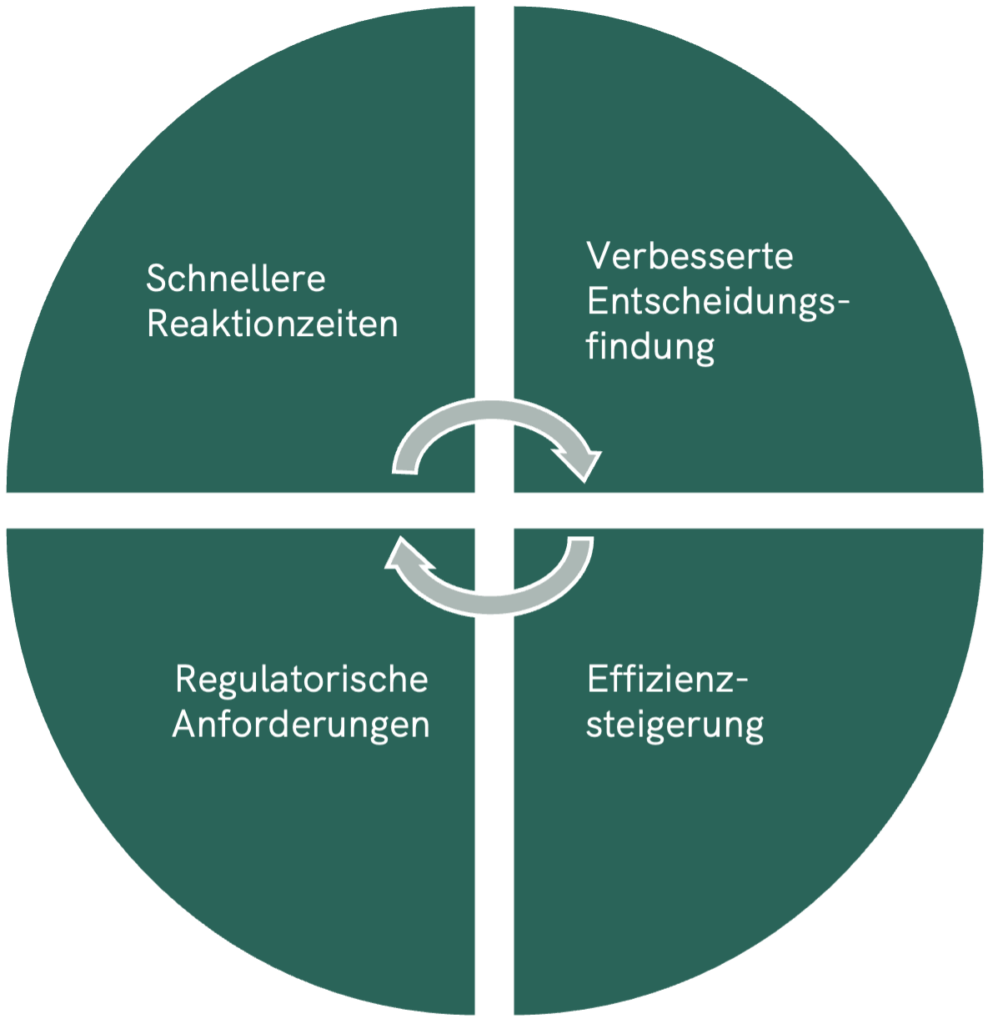

Auswirkungen der beschleunigten Datenerstellung auf das Risikomanagement

Die beschleunigte Datenerstellung und die immer größere Menge an verfügbaren Daten und Informationen hat weitreichende Auswirkungen auf das Risikomanagement von Banken. Durch effizientere Prozesse und den Einsatz innovativer Technologien können Banken nicht nur die Geschwindigkeit ihrer Risikobewertungen erhöhen, sondern auch die Qualität und Genauigkeit ihrer Modelle verbessern. Im Folgenden werden die wichtigsten Auswirkungen der beschleunigten Datenerstellung auf das Risikomanagement erläutert:

- Schnellere Reaktionszeiten

Eine effiziente Datenerfassung ermöglicht es Banken, schneller auf sich ändernde Marktbedingungen zu reagieren und ihre Risikobewertungen entsprechend anzupassen. Durch den Einsatz agiler Methoden und Technologien können Banken ihre Modell–entwicklungszyklen beschleunigen und die Zeit bis zur Implementierung neuer Modelle verkürzen. Dies ermöglicht es Banken, ihre Risikopositionen in Echtzeit zu überwachen und angemessen auf neue Risiken zu reagieren. - Verbesserte Entscheidungsfindung

Die Verfügbarkeit hochwertiger Daten in kürzerer Zeit ermöglicht es Banken, fundierte Entscheidungen zu treffen und die Risikoprofile ihrer Portfolien genauer zu bewerten. Durch die Integration verschiedener Datenquellen und die Nutzung fortgeschrittener Analysetechniken können Banken umfassende Darstellungen ihrer Risiken erhalten und bessere Entscheidungen über Kreditvergabe, Risikominderung und Kapitalallokation treffen. - Regulatorische Anforderungen

Eine effiziente Daten–erstellung ist entscheidend für die Erfüllung regulatorischer Anforderungen im Bereich des Risiko–managements. Banken müssen sicherstellen, dass ihre Daten–prozesse den geltenden Vorschriften entsprechen und dass ihre Modelle den Anforderungen der Aufsicht gerecht werden. Durch die Implementierung bewährter Praktiken zur Datenerstellung können Banken sicherstellen, dass sie regulatorische Standards einhalten und mögliche Bußgelder oder Sanktionen vermeiden. - Effizienzsteigerung

Die Optimierung der Prozesse zur Datenerfassung- und -verarbeitung trägt zur Effizienzsteigerung im Risikomanagement bei. Durch den Einsatz automatisierter Prozesse und Technologien können Banken den manuellen Arbeitsaufwand reduzieren und die Kosten für die Datenerstellung senken. Dies ermöglicht es Banken, ihre Ressourcen effektiver einzusetzen und die Rentabilität ihres Kreditgeschäfts zu verbessern.

Technologische Innovationen und zukünftige Trends

Technologische Innovationen spielen eine entscheidende Rolle bei der Transformation des Risikomanagements in der Finanzbranche. In Zukunft werden wir eine verstärkte Nutzung von Datenanalytik, künstlicher Intelligenz (KI/AI) und digitalen Plattformen sehen, um die Effizienz und Genauigkeit der Risikobewertung weiter zu verbessern.

Datenanalytik wird eine zentrale Rolle bei der Identifizierung von Risiken und Chancen spielen, indem sie eine gründlichere Analyse von großen Datenmengen ermöglicht. Fortgeschrittene Analysetechniken wie maschinelles Lernen und Predictive Analytics werden es Banken ermöglichen, Muster und Trends in den Daten zu erkennen und zukünftige Entwicklungen vorherzusagen.

Die Integration von künstlicher Intelligenz in das Risikomanagement wird ebenfalls stark zunehmen. KI-Algorithmen können komplexe Datenmuster identifizieren, Risiken quantifizieren und Entscheidungen automatisieren. Darüber hinaus können sie bei der Überwachung von Risiken in Echtzeit und der Identifizierung von Anomalien helfen, die auf potenzielle Probleme hinweisen könnten.

Digitale Plattformen werden eine Schlüsselrolle bei der Bereitstellung von Daten und Analysen für das Risikomanagement spielen. Durch die Nutzung von Cloud-Computing und Big-Data-Technologien können Banken auf eine breite Palette von Datenquellen zugreifen und ihre Analysen in Echtzeit durchführen. Dies ermöglicht es ihnen, schnell auf sich ändernde Marktbedingungen zu reagieren und fundierte Entscheidungen zu treffen.

Ein weiterer zukünftiger Trend ist die verstärkte Nutzung von ESG-Daten im Risikomanagement. Die Integration von Umwelt-, Sozial- und Governance-Kriterien in die Risikobewertung wird dazu beitragen, langfristige Risiken und Chancen besser zu verstehen und zu berücksichtigen. Banken werden zunehmend nachhaltige Kreditvergabepraktiken und verantwortungsbewusste Investitionen fördern, um die finanzielle Stabilität und die Nachhaltigkeit der Wirtschaft zu unterstützen.

Insgesamt werden technologische Innovationen das Risikomanagement in der Finanzbranche grundlegend verändern. Banken müssen sich auf diese Veränderungen vorbereiten, indem sie in die Entwicklung von Dateninfrastrukturen, Analysetechnologien und Fachkompetenzen investieren. Durch die Nutzung modernster Technologien und die Anpassung an zukünftige Trends können Banken ihre Wettbewerbsfähigkeit stärken und langfristigen Erfolg sichern.

Schlussfolgerungen

Die beschleunigte Datenerstellung und größere Menge an verfügbaren Daten hat das Potenzial, das Risikomanagement in der Finanzbranche grundlegend zu transformieren und die Effizienz sowie die Qualität der Risikobewertung zu verbessern. Durch den Einsatz innovativer Technologien, agile Prozesse und die Integration von externen Datenquellen können Banken ihre Dateninfrastrukturen optimieren und fundiertes Risikomanagement betreiben.

Die Fallstudien und Praxisbeispiele zeigen, dass Banken durch die Implementierung bewährter Praktiken und den Einsatz modernster Technologien signifikante Vorteile erzielen können. Eine effizientes Datenmanagement ermöglicht es Banken, schneller auf sich ändernde Marktbedingungen zu reagieren, fundierte Entscheidungen zu treffen und ihre Wettbewerbsfähigkeit zu stärken.

Die Zukunft des Risikomanagements liegt in der Nutzung von Datenanalytik, künstlicher Intelligenz und digitalen Plattformen, um Risiken frühzeitig zu identifizieren, zu quantifizieren und zu steuern. Banken müssen sich auf diese Veränderungen vorbereiten, indem sie in die Entwicklung ihrer Dateninfrastrukturen investieren und ihre Mitarbeiter mit den erforderlichen Fähigkeiten und Kenntnissen ausstatten.

Es ist wichtig, dass Banken weiterhin in die Optimierung ihrer Prozesse zur Datenerfassung und -verarbeitung investieren und sich an zukünftige Trends anpassen, um langfristigen Erfolg sicherzustellen. Durch eine kontinuierliche Weiterentwicklung und Anpassung an neue Herausforderungen können Banken ihre Risikomanagementpraktiken kontinuierlich verbessern und langfristiges Wachstum fördern.